Tabla de contenidos

Introducción: Las unidades de procesamiento gráfico o GPUs (tarjetas gráficas) han recorrido un largo camino desde sus inicios en los años 80 como simples controladoras de vídeo 2D hasta convertirse hoy en potentes procesadores paralelos esenciales para gaming, multimedia profesional e incluso inteligencia artificial (IA). A continuación, presentamos una cronología de los avances técnicos más significativos en GPUs (tanto de consumo como profesionales), analizamos juegos icónicos que marcaron hitos en su evolución (como Quake, Half-Life 2 o Crysis), detallamos arquitecturas clave de NVIDIA (Turing, Ampere, Ada Lovelace, etc. y sus planes futuros con Blackwell), y exploramos la estrecha relación entre las GPU y la revolución de la IA (CUDA, Tensor Cores, DLSS, LLMs, etc.). El objetivo es ofrecer una visión técnica pero divulgativa de cómo las tarjetas gráficas han evolucionado y del papel central que desempeñan hoy en gráficos RTX en tiempo real y en la era de la IA.

Cronología de Avances Técnicos en GPUs

Años 1980: Orígenes (2D) – Las primeras tarjetas de vídeo surgieron a finales de los 60 y 70 como controladoras muy básicas, capaces solo de mostrar texto o gráficos 2D simpleses.wikipedia.org. En 1981 IBM lanzó el adaptador MDA (Monochrome Display Adapter) con 4 KB de VRAM solo para texto, seguido ese mismo año por CGA (Color Graphics Adapter) que introdujo gráficos a 320×200 y 4 coloreses.wikipedia.orges.wikipedia.org. Estándares posteriores como EGA (1984) y VGA (1987) elevaron la resolución hasta 640×480 con 256 colores, sentando las bases de la PC gráficaes.wikipedia.org. Hasta finales de los 80, las “tarjetas gráficas” eran esencialmente controladoras 2D; los gráficos 3D en tiempo real aún estaban reservados a costosas estaciones de trabajo especializadas.

Mediados de 1990: Primeras GPUs 3D dedicadas – La explosión de los videojuegos en 3D llevó a la aparición de aceleradoras gráficas 3D para PC. En 1995 surgieron las primeras tarjetas 2D/3D para consumidores (de Matrox, S3, ATI, Creative, etc.), que añadían funciones de renderizado 3D al estándar SVGA tradicionales.wikipedia.org. Un hito clave fue el lanzamiento en 1996-97 de la 3Dfx Voodoo Graphics, una tarjeta 3D dedicada que ofrecía efectos avanzados como mip-mapping, Z-buffering y anti-aliasing, revolucionando los juegos de PCes.wikipedia.org. Estas tarjetas iniciales usaban el puerto PCI, cuyo ancho de banda pronto resultó insuficiente para tanto dato gráfico, por lo que Intel desarrolló el puerto AGP en 1997 para conectar GPUs con el CPU de forma más rápidaes.wikipedia.org. En esta época se popularizan APIs gráficas estandarizadas: Microsoft lanza Direct3D (DirectX) en 1996 y SGI promueve OpenGL, proporcionando interfaces comunes para aprovechar la aceleración 3D por hardwarees.wikipedia.org.

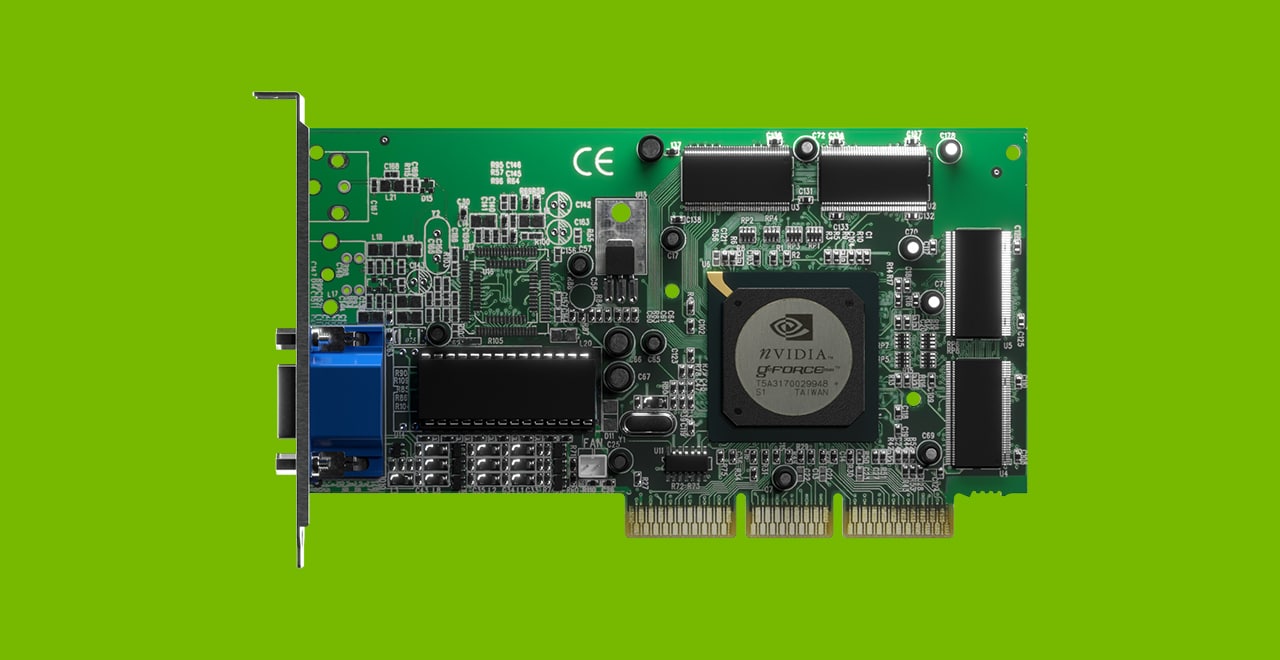

Finales de 1990: El término “GPU” y la era GeForce – En 1999, NVIDIA lanza la GeForce 256, primera tarjeta en integrar hardware dedicado de Transform & Lighting (T&L). NVIDIA acuñó para ella el término GPU (“Graphics Processing Unit”), ya que por primera vez una tarjeta realizaba no solo rasterizado, sino también cálculos geométricos (transformaciones 3D e iluminación) antes hechos por la CPUgeekom.esblogs.nvidia.com. Este avance liberó a la CPU de carga y permitió manejar escenas 3D mucho más complejas en tiempo realblogs.nvidia.com. Como destacó la prensa técnica en su día, la GeForce 256 podía “evitar cuellos de botella en la CPU y permitir a los desarrolladores usar muchos más polígonos, resultando automáticamente en mayor detalle”blogs.nvidia.com. La llegada de esta y sucesivas GeForce consolidó a NVIDIA, que dominó el mercado de tarjetas 3D entre 1999 y 2002 con modelos como GeForce 256, 2, 3 y 4 (mientras que 3dfx quebró en 2000 y fue adquirida por NVIDIA)es.wikipedia.org. La memoria de vídeo de las GPU creció rápidamente en ese periodo (de 32 MB en la GeForce 256 hasta 128 MB en la GeForce4 Ti) para soportar texturas más detalladases.wikipedia.org. En paralelo, ATI (competidor canadiense) lanzó su línea Radeon en 2000, con modelos como la Radeon 8500 y 9700 Pro que introdujeron soporte para DirectX 8.1 y 9 respectivamente, compitiendo fuertemente con NVIDIAgeekom.es. De hecho, la Radeon 9700 (2002) fue la primera GPU DirectX 9, adelantándose a NVIDIA en implementar pixel shaders de nueva generación.

Años 2000: Programabilidad y shaders unificados – A inicios de los 2000 se dio el salto de las tuberías fijas (Fixed Function) a las shader pipelines programables. DirectX 8 (2000) introdujo vertex y pixel shaders programables, permitiendo efectos de iluminación y materiales definidos por el desarrollador en lugar de una lista fija. La GeForce 3 (2001) y la Radeon 8500 (2001) soportaron estos primeros shaders (Modelo 1.x). Poco después, DirectX 9 (2002) amplió la longitud y precisión de los shaders (Modelo 2.0+), y la ya mencionada ATI Radeon 9700 Pro fue la primera GPU compatible DX9 completa, capaz de shader pixel complejos y HDR inicialgeekom.es. NVIDIA respondió con la GeForce FX (2003), aunque esta sufrió frente a ATI en rendimiento DX9. La siguiente gran revolución vino en 2006 con DirectX 10: se unificaron los distintos tipos de shaders en una arquitectura de propósito general (Unified Shader). NVIDIA estrenó este enfoque con la arquitectura Tesla en la GeForce 8800 GTX (noviembre 2006), la primera GPU DX10 del mercado, que integraba 128 ALUs unificadas capaces de ejecutar cálculos de vértices o píxeles según la cargaen.wikipedia.org. Esta GPU inauguró la era de los shaders unificados y arrasó en rendimiento para juegos DX9/DX10, marcando un salto enorme respecto a la generación anterior. ATI (adquirida por AMD en 2006) lanzó su propia arquitectura unificada con la Radeon HD 2900 XT (2007), aunque NVIDIA mantuvo liderazgo unos años. Hacia 2008-2009, las GPUs de ambas marcas alcanzaban ya el teraflop de potencia (p.ej. ATI Radeon HD 4870X2) y adoptaban memoria GDDR5 de alto ancho de bandageekom.es. En ese periodo también se introdujeron tecnologías multi-GPU como SLI y CrossFire, permitiendo a entusiastas usar dos o más tarjetas en paralelo para aumentar rendimiento gráfico.

Años 2010: GPUs como plataformas de cómputo (GPGPU) – En 2006, NVIDIA lanzó CUDA, una plataforma de programación paralelo que permitía usar la GPU para cómputo de propósito general (General-Purpose GPU, GPGPU) más allá de los gráficosen.wikipedia.org. CUDA proporcionó a desarrolladores acceso directo a la potencia paralela de las tarjetas GeForce/Quadro mediante C/C++ y librerías, sin necesidad de pasar por APIs gráficasen.wikipedia.org. Esto, junto con arquitecturas cada vez más versátiles, transformó a la GPU en un coprocesador masivo útil para simulaciones científicas, criptografía, renderizado por GPU y eventualmente inteligencia artificial. NVIDIA potenció esta visión con la arquitectura Fermi (GeForce GTX 480, 2010), que añadió cachés L1/L2 y soporte de enteros/IEEE754-2008 para hacer las GPUs más aptas para computación general. AMD por su parte desarrolló su arquitectura GCN (Graphics Core Next) desde 2011, optimizada también para cómputo paralelo. Durante esta década, vimos aumentar exponencialmente los núcleos y FLOPs de las GPUs: Kepler (GTX 680, 2012) y Maxwell (GTX 980, 2014) se centraron en eficiencia energética, permitiendo grandes saltos de rendimiento por vatio. En 2016 NVIDIA lanzó Pascal (GTX 1080, Tesla P100), migrando a 16 nm y utilizando memoria HBM2 en entornos profesionales, logrando más de 10 TFLOPs en una sola GPU. AMD lanzó sus Radeon RX 400/500 con arquitectura Polaris (2016) y luego Vega (2017), también superando los 10 TFLOPs y adoptando HBM2. Para finales de los 2010, las tarjetas gráficas se habían convertido en auténticos “supercomputadores” en miniatura con decenas de miles de threads en paralelo – situación que allanó el camino para su uso intensivo en deep learning e IA.

2017-2023: Ray Tracing en tiempo real e IA en gráficas – Un hito histórico llegó en 2018 con la arquitectura NVIDIA Turing (GeForce RTX 20), que fusionó rasterización tradicional con trazado de rayos en tiempo real. Las GPU Turing incorporaron por primera vez núcleos dedicados RT Cores para acelerar cálculo de intersecciones rayo-objeto, posibilitando reflejos e iluminación realistas en juegos en tiempo realnvidia.com. Además, añadieron núcleos Tensor Cores (inicialmente introducidos en 2017 en la Tesla V100 para centros de datos) enfocados a inferencia de IAnvidia.com. Gracias a ello, Turing trajo tecnologías como DLSS (Deep Learning Super Sampling), un sistema de escalado de imagen asistido por IA que mejora rendimiento renderizando a menor resolución y usando la GPU para reconstruir una imagen de alta calidadnvidia.com. Por primera vez, una GPU de consumo combinaba ray tracing + IA para gráficos. NVIDIA continuó esta línea con las arquitecturas Ampere (RTX 30, 2020) y Ada Lovelace (RTX 40, 2022), cada una doblando o triplicando el rendimiento en ray tracing e inferencia. Ampere introdujo mejoras como los Tensor Cores de 3ª generación con soporte a datos de precisión mixta (nuevo formato TF32 para facilitar entrenar IA con 32 bits efectivos)nvidia.com, compatibilidad bfloat16 y hasta INT4, además de soportar sparsity estructurada (omisión eficiente de pesos cero en redes neuronales) para acelerar hasta 2X los modelos dispersosnvidia.com. Ada Lovelace, por su parte, incorporó Shader Execution Reordering (SER) para optimizar la ejecución de shaders y aprovechar mejor la GPU (clave para mejorar el ray tracing)nvidia.com, núcleos RT de 3ª gen. más potentes, y núcleos Tensor de 4ª gen. junto a un Optical Flow Accelerator dedicado – pieza esencial de DLSS 3, que genera “frames intermedios” por IA elevando aún más los FPS en juegosnvidia.com. Todo esto ha permitido que juegos recientes ofrezcan gráficos casi foto-realistas con iluminación global vía trazado de rayos, algo impensable una década atrás.

Juegos Icónicos que Impulsaron la Evolución Gráfica

A lo largo de los años, ciertos videojuegos han sido benchmarks informales que empujaron a la industria de GPU a superarse, al exigir nuevos niveles de rendimiento o soporte de tecnologías gráficas avanzadas:

Quake (1996): el legendario FPS de id Software supuso un salto al 3D total y expuso las limitaciones de las CPU para renderizar gráficos poligonales complejos. Quake funcionaba en modo software, pero su versión adaptada GLQuake (1997) aprovechó las primeras tarjetas 3D (como 3Dfx Voodoo) para lograr texturas filtradas suavemente y mayor resolución, transformando la experiencia visualpcgamesn.com. De la noche a la mañana, jugar Quake con aceleración por hardware hacía que “pareciera un juego nuevo”, impulsando a miles de jugadores a comprar tarjetas 3D dedicadaspcgamesn.com. Este título inauguró la era en que disponer de una buena tarjeta gráfica se volvió imprescindible para jugar en PC. (Otros juegos coetáneos como Tomb Raider o Unreal (1998) también ofrecieron patches para 3Dfx, reforzando esta transición.)

Half-Life 2 (2004): casi una década después, este título de Valve mostró la madurez de los shaders programables y las físicas en tiempo real. Half-Life 2 presentaba gráficos muy avanzados para la época, con iluminación per-píxel, sombreado HDR (introducido poco después en una demo llamada Lost Coast), normal mapping en texturas y agua con reflejos/refracciones. Además, su Source Engine integraba un motor físico (Havok) que permitía interacciones realistas nunca vistas. Lo notable es que HL2 lograba todo eso manteniendo buen rendimiento en GPUs DX9 de gama mediaforums.totalwar.org, gracias a la eficiencia de su renderizado. Marcó un estándar de cómo un motor gráfico podía combinar grandes escenarios abiertos y entornos detallados con iluminación y físicas avanzadasforums.totalwar.org. Tras HL2, los jugadores comenzaron a esperar gráficos de alta fidelidad sin sacrificar framerate, lo que empujó a NVIDIA y ATI/AMD a seguir mejorando potencia y capacidades (soporte de Shader Model 3.0, 4.0, etc. en años siguientes).

Crysis (2007): el juego de Crytek se volvió sinónimo de exigencia gráfica. Lanzado junto a DirectX 10, Crysis presentaba un mundo abierto tropical con gráficos extremadamente detallados: vegetación frondosa, iluminación y sombras dinámicas en tiempo real, efectos climatológicos, físicas avanzadas y shaders vanguardistas (parallax occlusion mapping, subsurface scattering, etc.). Pocos PCs de 2007 podían mover Crysis en calidad High o Very High a resolución decente – incluso con una GeForce 8800 GTX de gama alta, el juego corría por debajo de 30 FPS en 1168×664pcgamer.com. Esto dio origen al meme “¿pero lo corre Crysis?”, usándose durante años para bromear sobre la potencia de cualquier hardware. Los propios creadores admitieron haber diseñado los ajustes ultra pensados en PCs futuros (2010 en adelante)pcgamer.com. Crysis fue un arma de doble filo: por un lado, impulsó a NVIDIA y AMD a lanzar GPUs más potentes y optimizar drivers (Crysis se usó como test en prácticamente todos los análisis de tarjetas gráficas de la época); por otro lado, mostró que perseguir el máximo realismo podía dejar a la mayoría de jugadores atrás. Tras Crysis, se moderó la carrera por el fotorealismo “inmediato” y se puso más foco en eficiencia (no obstante, su legado técnico perdura – por ejemplo, su engine inauguró técnicas de rendering diferido, uso intensivo de multi-core, y fue base de futuros títulos).

Otros hitos recientes: Battlefield 3 (2011) popularizó la teselación y destrucción dinámica apoyada en GPU; The Witcher 3 (2015) y GTA V (2015 en PC) elevaron el listón en mundos abiertos con clima dinámico; Minecraft RTX (2020) y Portal RTX (2022) demostraron las posibilidades de la path tracing total con GPUs RTX modernas. Cada nueva generación de juegos punteros sigue forzando a las gráficas a innovar. Sin ir más lejos, Cyberpunk 2077 (2020) con su modo Overdrive (parche 2023) requiere las GPU más potentes actuales para trazado de rayos con path tracing, anticipando lo que serán los gráficos next-gen.

Arquitecturas Clave de GPU (Turing, Ampere, Ada Lovelace y más)

A continuación, profundizamos en varias arquitecturas de GPU destacadas (principalmente de NVIDIA en la última década) que ilustran la evolución reciente en diseño de tarjetas gráficas, así como un vistazo a planes futuros:

NVIDIA Turing (2018) – Introducida con las GeForce RTX 20 (como RTX 2080 Ti) y Quadro RTX, Turing supuso “el mayor salto desde la invención de CUDA en 2006” según NVIDIAnvidia.com. Por primera vez, una GPU incorporaba hardware dedicado para ray tracing en tiempo real: los RT Cores. Cada RT Core podía calcular hasta 10 giga-rays/s (intersecciones de rayos), acelerando en hasta 25 veces el trazado de rayos frente a la generación anterior (Pascal)nvidia.com. Esto hizo posible efectos de reflejos, refracciones y sombras físicamente precisos en juegos, considerados el “Santo Grial” de los gráficosnvidia.com. Turing también integró núcleos tensoriales especializados para IA, capaces de 500 billones de operaciones tensoriales por segundonvidia.com, orientados a acelerar deep learning e inferencia. Gracias a ellos, se implementó DLSS 1.0, donde una red neuronal entrenada reconstruía frames a alta resolución a partir de imágenes renderizadas a menor res, obteniendo grandes aumentos de rendimiento con mínima pérdida visual. Además, Turing rediseñó el multiprocesador de streaming (SM) permitiendo ejecutar simultáneamente cargas de enteros y flotantes (mejorando shader throughput) e introdujo nuevas técnicas de shading como Variable Rate Shading (VRS), texture-space shading y multi-view rendering, útiles para VR y renderizar más eficientemente escenas complejasnvidia.com. Fabricada en 12 nm y con hasta 18.6 mil millones de transistores (TU102), Turing fue un punto de inflexión: sentó las bases de la era del RTX (gráficos + IA).

NVIDIA Ampere (2020) – Es la arquitectura de las GeForce RTX 30 (ej: RTX 3080/3090) y de GPUs de centro de datos como la A100. Ampere llevó el rendimiento bruto a nuevos niveles con hasta 28 mil millones de transistores (GA102 en RTX 3090) en 8 nm, y 54 mil millones en el chip A100 de 7 nm (SMX para HPC). En Ampere se introdujeron núcleos tensor de 3ª generación con soporte de nuevos formatos numéricos, destacando Tensor Float 32 (TF32) – un formato de 19 bits que permite a los desarrolladores de IA entrenar con la facilidad de usar 32 bits pero con el rendimiento cercano a 16 bits, obteniendo aceleraciones de hasta 20× en AI sin cambiar códigonvidia.com. Ampere también añadió soporte nativo a FP64 en tensor cores para computación científica de alta precisiónnvidia.comnvidia.com. En el lado gráfico, las GeForce Ampere duplicaron aproximadamente el rendimiento en ray tracing vs Turing, gracias a núcleos RT de 2ª generación más eficientes y a shaders más rápidos. Otra novedad fue la memoria GDDR6X en modelos superiores, elevando anchos de banda a ~1 TB/s. En las variantes de centro de datos (A100), Ampere introdujo MIG (Multi-Instance GPU) – capacidad de particionar una GPU física en hasta 7 GPU lógicas aisladas para servir a múltiples usuarios o trabajos simultáneamentenvidia.com – y soporte de estructuras sparse en inferencia: los tensor cores Ampere pueden aprovechar matrices dispersas (con 50% de ceros) para obtener hasta 2× FLOPs efectivas sin pérdida de precisión apreciablenvidia.com. En resumen, Ampere fortaleció tanto el ray tracing en tiempo real como el desempeño en IA y computación, consolidando la convergencia de gráficos tradicionales e IA en una misma GPU.

NVIDIA Ada Lovelace (2022) – Arquitectura de las GeForce RTX 40 (ej: RTX 4090) y también de GPUs profesionales como RTX 6000 Ada. Construida en 4N (4 nm optimizado de TSMC) con hasta 76 mil millones de transistores (AD102 en RTX 4090), Ada supuso otro salto significativo. Sus núcleos RT de 3ª generación implementaron mejoras para acelerar path tracing y ray tracing de nivel cinematográfico, e incorporaron la tecnología Shader Execution Reordering (SER) que reorganiza dinámicamente las cargas de trabajo de shading para maximizar la utilización de los núcleosnvidia.com. NVIDIA afirma que SER puede mejorar el rendimiento de shaders en ray tracing en 2-3× en escenas complejasnvidia.com. Ada también presentó los núcleos Tensor de 4ª generación con mayor throughput y añadió un Optical Flow Accelerator (OFA) dedicado, pieza clave para DLSS 3. DLSS 3 (exclusivo de Ada) no solo escala la resolución como las versiones anteriores, sino que genera frames intermedios completos mediante IA aprovechando el OFA (que calcula el flujo de movimiento entre frames)nvidia.com. Esto permite multiplicar los FPS incluso cuando la GPU está al límite rasterizando, aunque con algo de latencia adicional (mitigada en parte por NVIDIA Reflex). En cuanto a vídeo, Ada dobló la capacidad de codificación/decodificación e introdujo soporte total a códec AV1 por hardware, pudiendo manejar hasta 3× más streams simultáneos que Amperenvidia.com – un guiño a su uso en creación de contenido, streaming y realidad virtual/aumentadanvidia.comnvidia.com. Ada está diseñada tanto para gaming extremo en 4K+ray tracing, como para aplicaciones profesionales de visualización, IA y cálculo: NVIDIA la califica de arquitectura para “un nuevo nivel de rendimiento, marcando un punto de inflexión en IA, raytracing y gráficos neuronales”nvidia.com. Con Ada, por primera vez una sola GPU (RTX 4090) puede manejar path tracing en juegos (ej. Portal RTX) a frame rates jugables mediante DLSS 3, demostrando el nivel que ha alcanzado el hardware gráfico.

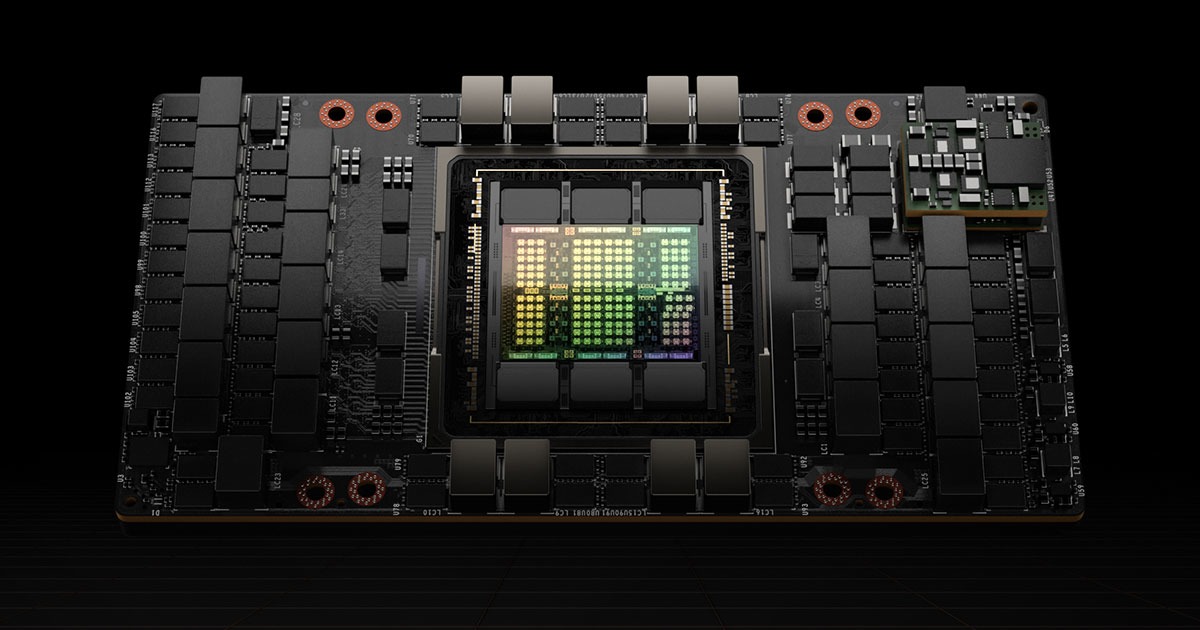

Planes futuros: NVIDIA Blackwell y más allá – Mirando al futuro cercano, NVIDIA ha anunciado la arquitectura de próxima generación con nombre código Blackwell (en honor al científico David Blackwell). Se espera que Blackwell alimente tanto las GeForce RTX 50 Series para gaming (previstas alrededor de 2025) como las GPU de centro de datos serie B. Según lo revelado por NVIDIA, Blackwell representa “el motor de la nueva revolución industrial de la IA”, con enfoque en rendimiento, eficiencia y escalabilidad sin precedentesnvidia.com. Técnicamente, las GPUs Blackwell implementarían por primera vez un diseño multi-chip (MCM): todos los productos Blackwell constarían de dos “dies” (chips) en un mismo paquete, fabricados en un nodo optimizado 4N de TSMC, sumando la asombrosa cifra de 208 mil millones de transistores interconectados a 10 TB/snvidia.com. Esto les daría una potencia bruta muy superior a Ada (que ya tenía 76 mil millones en un solo die). En el ámbito de IA, Blackwell incorporará la 2ª generación del Transformer Engine, optimizado para acelerar modelos de Large Language Model (LLM) e IA generativanvidia.com. Los Blackwell Tensor Cores añadirán nuevas precisiones de ultra-baja cuantía (incluso formatos de 4 bits FP4), aplicando técnicas de microescala para mantener la exactitud con tan pocos bitsnvidia.com. Según NVIDIA, unos “Ultra Tensor Cores” en Blackwell ofrecerán 1.5× más FLOPs de IA y el doble de rendimiento en la parte de atención de transformers respecto a Hoppernvidia.com. Además, Blackwell integrará de serie tecnologías de computación confidencial para ejecutar cargas de IA cifradas de extremo a extremo (importante para seguridad de datos y propiedad intelectual)nvidia.com, y una 5ª gen de interconexión NVLink capaz de unir hasta 576 GPUs cooperando en clúster (pensando en exascala y modelos con trillones de parámetros)nvidia.com. En cuanto a gráficos, no se han detallado aún, pero es de esperar núcleos RT/Tensor de nueva generación aún más potentes y posiblemente nuevas técnicas de rasterización. Si las previsiones se cumplen, Blackwell marcará otro gran salto tanto en RTX gaming (rumores hablan de >2× rendimiento vs RTX 4090 en rasterización y trazado de rayos, junto con memoria GDDR7 más rápida)tomshardware.comtomshardware.com, como especialmente en entreno de IA y cómputo científico, consolidando a la GPU como “el cerebro” de la computación moderna. Más allá de Blackwell, NVIDIA no ha revelado nombres, pero históricamente sigue nombrando arquitecturas por científicos célebres – tras Ada Lovelace, Hopper y Blackwell, la próxima podría llevarnos a otro pionero/a (¿Shannon, Babbage, etc.?). Lo claro es que cada generación seguirá aumentando la integración (quizá con chiplets apilados 3D, memoria HBM integrada en gaming, etc.) y la especialización para gráficos híbridos con IA.

Comparativa de arquitecturas NVIDIA recientes: Para resumir, presentamos una tabla con las características clave de Turing, Ampere, Ada y Hopper (H100) de NVIDIA, pilares de la segunda mitad de la década de 2010 y principios de 2020, previas a Blackwell:

| Arquitectura (Año) | Proceso | Núcleos CUDA (ejemplo) | Novedades principales |

|---|---|---|---|

| Turing (2018) – RTX 20 | 12 nm (FFN) | 4352 (RTX 2080 Ti) | 1ª gen RT Cores (ray tracing real-time) y Tensor Cores en gaming. Shading avanzado: VRS, mesh shaders, etcnvidia.comnvidia.com. |

| Ampere (2020) – RTX 30 / A100 | 8 nm Samsung (GA102); 7 nm TSMC (GA100) | 10496 (RTX 3090) / 6912 (A100) | 2ª gen RT Cores; 3ª gen Tensor Cores con nuevos formatos (TF32, BF16, FP64)nvidia.com. Soporte sparsity (modelos IA 2×)nvidia.com. Versión data-center con MIG (multi-GPU virtual)nvidia.com. |

| Ada Lovelace (2022) – RTX 40 | 4 nm (TSMC 4N) | 16384 (RTX 4090) | 3ª gen RT Cores + Shader Execution Reordering (mejora ray tracing ~25%)nvidia.com. 4ª gen Tensor Cores + OFA (Optical Flow Accelerator) para DLSS 3 (frames por IA)nvidia.com. Dual AV1 encode, mayor eficiencia. |

| Hopper (2022) – H100 (Data Center) | 4 nm (TSMC 4N) | 16896 (H100 SXM) | GPU orientada a IA: FP8 Transformer Engine (hasta 6-9× training vs A100)blogs.nvidia.com. 80 GB HBM3. Nuevas instrucciones DPX (dinámica programación) y mejoras multi-instancia. Sin núcleos gráficos/RT (no gaming). |

(Nota: CUDA cores en ejemplo de modelo tope de gama de cada arquitectura; RTX 4090 en Ada, etc.)

GPU e Inteligencia Artificial: de CUDA a la era de los LLM

La relación entre las GPUs y la inteligencia artificial merece mención aparte. Paradójicamente, las tarjetas gráficas fueron ideadas para juegos, pero sus capacidades únicas las han convertido en el motor de la revolución de la IA en la última década. A continuación, vemos cómo ha evolucionado esta sinergia:

CUDA y el inicio del GPGPU (2006–2012)

Durante muchos años, las GPUs se usaron casi exclusivamente para gráficos. Sin embargo, alrededor de 2006 emergió la idea de aprovechar su paralelismo masivo para otras tareas de cómputo científico. NVIDIA se adelantó lanzando la plataforma CUDA en 2006, permitiendo a desarrolladores programar la GPU directamente en C/C++en.wikipedia.org. CUDA (Compute Unified Device Architecture) abstraía las unidades de cálculo de la GPU (hilos, bloques, memoria compartida, etc.) de forma flexible, a diferencia de shaders gráficos fijosen.wikipedia.org. Esto abrió la puerta a usar GPUs GeForce/Tesla en problemas de alto paralelismo: simulaciones físicas, genética, análisis financiero, etc. La comunidad científica rápidamente adoptó esta idea; por ejemplo, se usaron GPUs para acelerar proyectos de química cuántica, análisis de datos astronómicos y másblogs.nvidia.com. Un momento clave llegó en 2011-2012, cuando investigadores de IA (Geoff Hinton, Andrew Ng, entre otros) descubrieron que las GPUs podían acelerar redes neuronales profundas decenas de veces respecto a CPUsblogs.nvidia.com. En 2012, el modelo de visión artificial AlexNet (Krizhevsky et al.) fue entrenado en dos GPU NVIDIA GTX 580, ganando arrasadoramente la competición ImageNet de reconocimiento de imágenesblogs.nvidia.comblogs.nvidia.com. Este hito marcó el inicio de la era del deep learning: se demostró que la combinación de big data, nuevos algoritmos (redes profundas) y la potencia de las GPUs podía lograr en visión y percepción resultados hasta entonces inalcanzablesblogs.nvidia.com. De repente, la GPU dejó de ser solo para gráficos: pasó a ser una herramienta indispensable en laboratorios de IA de todo el mundo. Empresas como Google, Microsoft, Facebook empezaron a montar granjas de cientos o miles de GPUs para entrenar sus sistemas de reconocimiento de voz, imágenes, traducción, etc.blogs.nvidia.comblogs.nvidia.com.

Tensor Cores: hardware especializado para IA (2017)

A medida que crecía la demanda de GPUs para IA, los fabricantes comenzaron a optimizarlas específicamente para ese propósito. NVIDIA introdujo en 2017 (arquitectura Volta, Tesla V100) los primeros Tensor Cores, unidades en las SM diseñadas para multiplicar y acumular matrices de 4×4 eficientemente en baja precisión (FP16/INT8). Un solo Tensor Core puede realizar 64 operaciones FMA 4×4 por ciclo, algo ideal para los cálculos de las capas de una red neuronal. En la práctica, una Tesla V100 de 2017 alcanzaba 125 TFLOPs en precisión media (FP16), cuando su antecesora Pascal P100 apenas llegaba a ~20 – es decir, hasta 12× más rápido en entrenamiento de deep learningdatacrunch.iodatacrunch.io. Esta fue una mejora radical. Aunque inicialmente orientados a entornos HPC/servidor, pronto (con Turing 2018) los Tensor Cores llegaron también a GPUs de consumo, aprovechados por ejemplo en técnicas como DLSS para juegos. Las generaciones posteriores ampliaron sus capacidades: Tensor Cores de 2ª gen (Turing) soportaron arithmetic intensity mayor y nuevas precisiones enteras; 3ª gen (Ampere) añadieron TF32 y soporte nativo a sparsity (permitiendo que un 50% de pesos nulos duplique throughput efectivo)nvidia.comnvidia.com; 4ª gen (Ada/Hopper) introdujeron soporte a FP8, multiplicando por 4 la tasa de cómputo vs FP16 a costa de mínima pérdida de precisión (gracias a escalados y algoritmos adaptativos). Hoy día, los Tensor Cores permiten a una sola GPU Ampere o Ada realizar petaflops (10^15 operaciones) en inferencia de redes profundas. Esto ha sido crucial para entrenar modelos gigantes: por ejemplo, NVIDIA señaló que su Hopper H100 con Tensor Cores FP8 logra hasta 9× más rendimiento que su predecesor A100 en entrenamiento de transformers de gran tamañoblogs.nvidia.com.

DLSS y la IA aplicada a gráficos

Otra manifestación de la unión de GPU + IA es DLSS (Deep Learning Super Sampling), introducido por NVIDIA junto con Turing (2018). DLSS es un conjunto de técnicas de upscaling de imagen en tiempo real mediante deep learning. La idea es renderizar un juego a menor resolución nativa (por ejemplo 1080p) para ganar FPS, y luego una red neuronal convolucional entrenada rellena los detalles para obtener una imagen final en alta resolución (ej. 4K) que se vea casi como renderizada nativamenteen.wikipedia.org. Para ello, las GPUs RTX calculan ciertos buffers (vectores de movimiento, etc.) y ejecutan la inferencia de la red en sus Tensor Cores. DLSS 1.0 inicialmente usó un modelo entrenado por NVIDIA que no siempre conservaba la calidad, pero DLSS 2.0 (2020) mejoró drásticamente al usar feedback temporal (múltiples frames) y un modelo general más robusto, logrando calidad prácticamente indistinguible del render nativo a una fracción del coste. DLSS 3 (2022, exclusivo RTX 40) fue más allá al generar también frames completos (no solo píxeles) – lo que requiere predicción de movimiento mediante el Optical Flow Accelerator y luego sintetizar un frame intermedio por IAnvidia.com. Estas técnicas han resultado muy beneficiosas: gracias a DLSS, juegos pesados con ray tracing (que reducirían cualquier GPU sin IA a <30 FPS) pueden superar 60 o 100 FPS manteniendo buena fidelidad visual. Esto demuestra cómo la IA integrada en las tarjetas gráficas abre nuevas vías para mejorar la experiencia de juego más allá de la pura fuerza bruta.

NVIDIA en la era de los LLM y el Big Data

Hoy por hoy, la IA a gran escala – entrenar modelos con millones de millones de parámetros (los llamados Large Language Models, como GPT-3, GPT-4, etc.) – sería imposible sin GPUs. NVIDIA se ha posicionado como líder absoluto en este campo: sus GPUs para data centers (Tesla/Quadro, ahora llamados A100, H100, etc.) equipan la mayoría de los supercomputadores de IA. Por ejemplo, OpenAI entrenó GPT-3 (2020) utilizando más de 10 000 GPUs NVIDIA V100 (Volta) durante semanasdatacrunch.io, dado que cada GPU podía procesar trillones de operaciones por segundo pero el modelo requería quintillones. Esto ilustra la escala: 10 mil GPUs trabajando en paralelo para un solo modelo de IA. Hoy en día, los centros de datos en la nube ofrecen instancias con hasta 8× A100 o H100 en un nodo, interconectadas vía NVLink/NVSwitch para actuar como una sola “mega-GPU”. NVIDIA ha desarrollado todo un ecosistema de software (bibliotecas como cuDNN para acelerar operaciones neuronales, frameworks como TensorRT para desplegar modelos, y herramientas de gestión como CUDA-X) que han contribuido a su dominio. En 2023, ante el auge de aplicaciones tipo ChatGPT, la demanda de GPUs NVIDIA H100 se disparó – convirtiéndose en “las nuevas reservas de petróleo” para las big tech, ya que poseer más GPUs equivale a poder entrenar modelos más avanzados. Competidores como Google han creado hardware dedicado (TPUs), y AMD ofrece su línea MI200/MI300, pero hasta ahora ninguna alternativa ha desplazado a las GPU NVIDIA en versatilidad y rendimiento para IA a gran escala.

En conclusión, las tarjetas gráficas modernas son híbridos entre renderizadores de gráficos ultra-realistas y aceleradores de inteligencia artificial. Desde manejar reflejos fotorrealistas en un videojuego hasta entrenar un modelo de lenguaje que pueda sostener una conversación, la GPU se ha vuelto el corazón del cómputo intensivo. Y su evolución no se detiene: con cada nueva generación (RTX, IA), las GPUs siguen ampliando fronteras, difuminando la línea entre gráficos y computación general. Sin duda, estamos en la “era dorada” de las GPUs – unos componentes que nacieron para dibujar polígonos y hoy impulsan tanto el entretenimiento digital como los mayores avances en supercomputación e inteligencia artificial.

Referencias (citas):

Evolución histórica de tarjetas de vídeo 2D (MDA, CGA, VGA)es.wikipedia.orges.wikipedia.org.

Aparición de primeras aceleradoras 3D en 1995 (Matrox, S3, ATI)es.wikipedia.org.

Impacto de 3Dfx Voodoo (1997) con nuevos efectos 3D y necesidad de AGPes.wikipedia.orges.wikipedia.org.

Dominio de NVIDIA (1999-2002) tras GeForce 256; aumento de memoria de 32MB a 128MBes.wikipedia.org.

Competencia NVIDIA vs ATI (liderazgo compartido en 2006 tras compra de ATI por AMD)es.wikipedia.org.

GeForce 256 (1999) introducida como “primer GPU” con T&L por hardwaregeekom.esblogs.nvidia.com.

GeForce 256 alivia a la CPU permitiendo más polígonos y detalleblogs.nvidia.com.

Quake/GLQuake (1996-97) impulsó ventas de tarjetas 3D por mejoras gráficas evidentespcgamesn.com.

Half-Life 2 (2004) – motor Source impresiona con gráficos avanzados en grandes mapasforums.totalwar.org.

Crysis (2007) – incluso hardware tope de 2007 no alcanzaba 30fps en altopcgamer.com; diseñado con gráficos “future-proof”pcgamer.com.

Turing (2018) – RT Cores + Tensor Cores hacen posible ray tracing en tiempo realnvidia.comnvidia.com y aceleran IA en gráficos (denoising, scaling)nvidia.com.

Shading mejorado en Turing: VRS, etc., mejora raster y VRnvidia.com.

Ampere (2020) – introduce TF32 y FP64 en Tensor Cores para IA y HPCnvidia.com; soporta sparsity 2:4 que duplica rendimiento en modelos dispersosnvidia.com.

Ada (2022) – RT cores mejorados con Shader Execution Reordering (optimiza ray tracing)nvidia.com; Tensor Cores 4ª gen y Optical Flow Accelerator para DLSS 3nvidia.com.

Ada acelera aplicaciones IA: Tensor Cores optimizados para chatbots, NLP, visión, DLSS 3nvidia.com.

Blackwell (próxima gen) – ~208 mil millones transistores en diseño chiplet (2 dies)nvidia.com; 2ª gen Transformer Engine con formatos de precisión microscaling (FP4)nvidia.com.

Blackwell Ultra Tensor Cores: +2× rendimiento en capas de atención vs gen anteriornvidia.com.

CUDA (2006) permitió usar GPUs para computación general (GPGPU) de forma unificadaen.wikipedia.orgen.wikipedia.org.

AlexNet (2012) se entrenó en GPUs NVIDIA y ganó competencia ImageNet, superando modelos previos y marcando el boom del deep learningblogs.nvidia.comblogs.nvidia.com.

NVIDIA V100 (2017, Volta) introdujo Tensor Cores, hasta 12× más rápidos que Pascal en entrenamiento IAdatacrunch.iodatacrunch.io.

DLSS utiliza deep learning para reescalar imágenes, ejecutándose en Tensor Cores; objetivo: renderizar a menor res y reconstruir en alta para mejorar rendimientoen.wikipedia.org.

GPUs NVIDIA dominan entrenamiento de LLMs: OpenAI usó 10 000 GPUs V100 para entrenar GPT-3datacrunch.io (clúster provisto por Microsoftdeveloper.nvidia.com).

Hopper H100 (2022) con Transformer Engine FP8 logra hasta 9× más throughput en training e 30× en inferencia vs generación anteriorblogs.nvidia.com.